Premiere für fliegende autonome Killerroboter

Wurde in Libyen ein fliegender Killerroboter eingesetzt? Gut möglich

meint Zachary Kallenborn am 20. Mai 2021 vom Bulletin of Atomic Scientists

Ein Screenshot aus einem Werbevideo für die Kargu-Drohne. Im Video taucht die Waffe auf ein Ziel zu, bevor sie explodiert.

Im vergangenen Jahr könnte in Libyen eine in der Türkei hergestellte autonome Waffe, die STM Kargu-2-Drohne, Soldaten die sich zurückgezogen hatten und dem libyschen General Khalifa Haftar loyal sind „gejagt und aus der Ferne engagiert“ haben. Das vermutet ein kürzlich veröffentlichter Bericht des UN- Expertengremiums über Libyen.

Im Laufe des Jahres war die von der UN anerkannte Regierung Lybiens „Die Nationale Vereinbarung der Kräfte des Allgemeinen“ zurück. Des wurde signalisiert aus der Hauptstadt Tripoli signalisiert, dass sie die Oberhand in dem libyschen Konflikt gewonnen hatten. Aber Kargu-2 bedeutet hat vermutlich auch globale Bedeutung:

ein neues Kapitel der autonomen Waffen, in dem sie verwendet werden, um Menschen auf der Grundlage künstlicher Intelligenz zu bekämpfen und zu töten.

Zachary Kallenborn am 20. Mai 2021

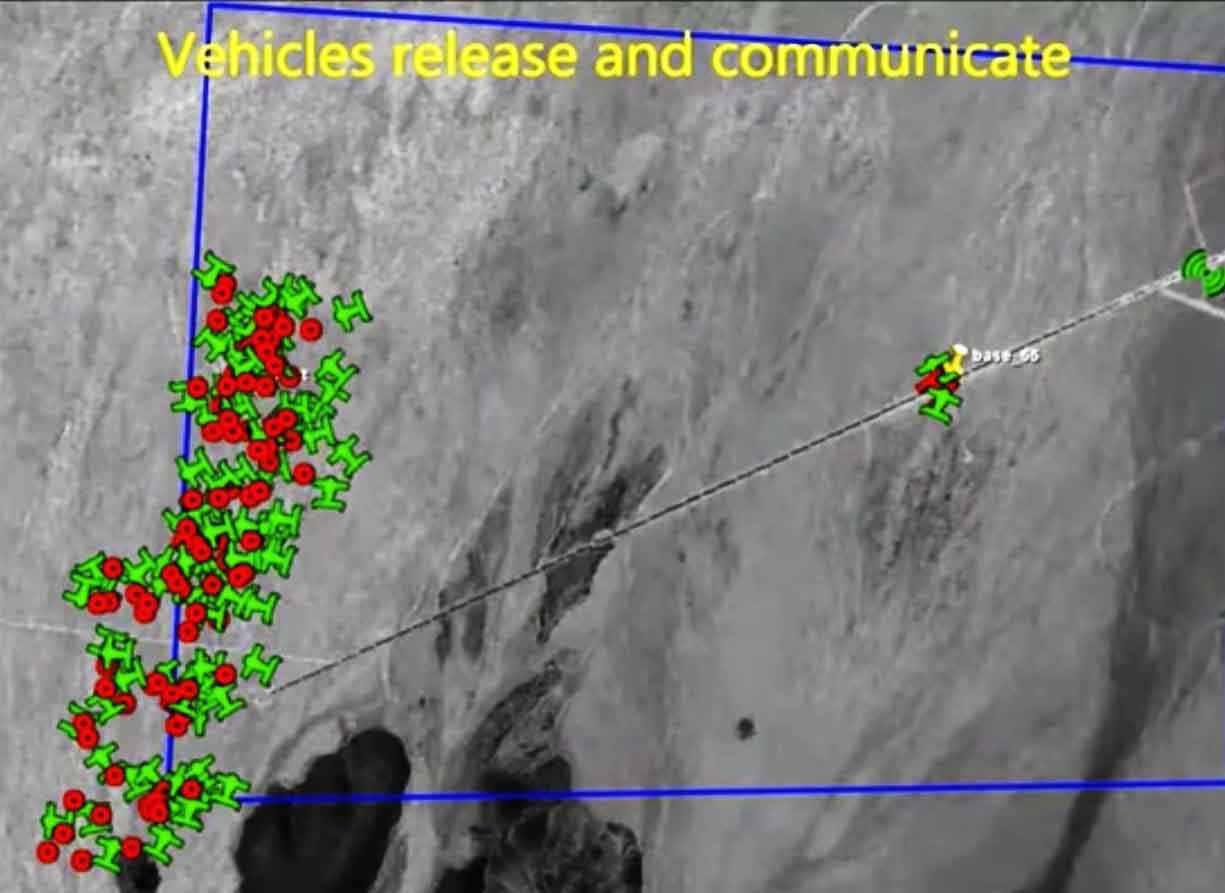

Die Kargu ist eine „loitering“ Drohne , die auf maschinellem Lernen basierte Objektklassifikations-Ziele auswählen und eingreifen kann. Und zwar mit Schwarm Fähigkeiten. Sie kann mit 20 Drohnen zusammenarbeiten.

Der UN-Bericht bezeichnet Kargu-2 als tödliche autonome Waffe. Der Hersteller STM wirbt in einem düsteren Video für den „Antipersonen“-Fähigkeiten der Waffe. Ein Kargu-Modell in einem steilen Sturzflug auf ein Ziel inmitten einer Gruppe von Puppen wird zeigt.

Wenn jemand bei einem derartigen autonomen Angriff getötet wurde, wäre dies wahrscheinlich der historisch erste bekannter Fall in der Barbarisierung der Lüfte 4.0.

Barbarisierung des Luftraums 4.0

Die Tötung von Menschen aus der Luft hatte ja bereits 1911 in Lybien ihre Premiere. Fried und Suttner forderten bereits damals ein Verbot jeglicher Luftwaffen. Auf künstlicher Intelligenz basierende autonome Waffen zum Töten aus Luft wären ein weiter Dammbruch in der Geschichte der Menschheit.

Der UN-Bericht deutet stark darauf hin, dass tödliche autonome Waffensysteme zu erheblichen Opfern durch das bemannte Boden-Luft-Raketensystem Pantsir S-1 geführt haben. Es wird aber im Bericht, laut Zachary Kallenborn nicht ausdrücklich darauf hingewiesen.

Viele Leute , darunter Steven Hawking und Elon Musk, haben gesagt, dass sie diese Art von Waffen verbieten wollen und sagen, dass sie nicht zwischen Zivilisten und Soldaten unterscheiden können, während andere sagen, dass sie bei der Abwehr schnelllebiger Bedrohungen wie Drohnenschwärmen und könnte das Risiko für Zivilisten sogar verringern , weil sie weniger Fehler machen als von Menschen geführte Waffensysteme. Die Regierungen der Vereinten Nationen debattieren, ob neue Beschränkungen für den Einsatz autonomer Waffen im Kampf erforderlich sind. Was die Weltgemeinschaft jedoch nicht ausreichend getan hat, ist ein gemeinsames Risikobild zu entwickeln. Die Abwägung von Risiko-Nutzen-Kompromissen hängt von persönlichen, organisatorischen und nationalen Werten ab, aber die Bestimmung des Risikos sollte objektiv sein.

Es ist nur eine Frage der Statistik.

Auf der höchsten Ebene ist das Risiko ein Produkt aus Wahrscheinlichkeit und Folge von Fehlern. Jede bestimmte autonome Waffe hat eine gewisse Chance, etwas zu vermasseln, aber diese Fehler können eine Vielzahl von Konsequenzen haben. Die autonomen Waffen mit dem höchsten Risiko sind solche, die eine hohe Fehlerwahrscheinlichkeit aufweisen und dabei viele Menschen töten. Fehlzündungen einer .357 Magnum ist eine Sache; einen W88-Atomsprengkopf versehentlich zur Detonation zu bringen, ist etwas anderes.

Es gibt mindestens neun Fragen, die wichtig sind, um zu verstehen, wo die Risiken bei autonomen Waffen liegen.

Wie entscheidet eine autonome Waffe, wen sie tötet? Landminen – in gewisser Weise eine extrem einfache autonome Waffe – verwenden Drucksensoren, um zu bestimmen, wann sie explodieren. Die Schussschwelle kann variiert werden, um sicherzustellen, dass die Landmine nicht explodiert, wenn ein Kind sie aufhebt. Herumlungernde Munition wie die israelische Harpyie erkennt und ortet normalerweise feindliche Radarsignaturen. Wie bei Landminen kann die Empfindlichkeit eingestellt werden, um ziviles vom militärischen Radar zu trennen. Und zum Glück senden Kinder keine starken Radiowellen aus.

Was jedoch internationale Besorgnis ausgelöst hat, ist die Einbeziehung der auf maschinellem Lernen basierenden Entscheidungsfindung, wie sie im Kargu-2 verwendet wurde. Diese Waffentypen arbeiten mit softwarebasierten Algorithmen, die durch große Trainingsdatensätze „beigebracht“ werden, um beispielsweise verschiedene Objekte zu klassifizieren. Computer-Vision-Programme können trainiert werden, um Schulbusse, Traktoren und Panzer zu identifizieren. Aber die Datensätze, mit denen sie trainieren, sind möglicherweise nicht ausreichend komplex oder robust, und eine künstliche Intelligenz (KI) kann die falsche Lektion „lernen“. In einem Fall erwog ein Unternehmen, eine KI einzusetzen, um Einstellungsentscheidungen zu treffenbis das Management feststellte, dass das Computersystem glaubte, dass die wichtigste Qualifikation für Jobkandidaten darin bestand, Jared zu heißen und Highschool-Lacrosse zu spielen. Die Ergebnisse wären überhaupt nicht komisch, wenn eine autonome Waffe ähnliche Fehler machen würde. Autonome Waffenentwickler müssen die Komplexität antizipieren, die dazu führen könnte, dass ein maschinelles Lernsystem die falsche Entscheidung trifft. Die Black-Box- Natur des maschinellen Lernens, bei der die Entscheidungen des Systems oft undurchsichtig sind, bringt zusätzliche Herausforderungen mit sich.VERBUNDEN:Besorgt über die autonomen Waffen der Zukunft? Schau dir an, was schon schief gelaufen ist

Welche Rolle hat der Mensch? Menschen könnten in der Lage sein, darauf zu achten, dass etwas schief geht. In Human-in-the-Loop-Konfigurationen überwacht ein Soldat autonome Waffenaktivitäten und kann, wenn die Situation in eine schreckliche Richtung zu gehen scheint, eine Korrektur vornehmen. Wie die gemeldete Verwendung des Kargu-2 zeigt, macht ein menschlich-off-the-Loop-System einfach seine Sache ohne Schutz. Aber einen Soldaten in der Schleife zu haben, ist kein Allheilmittel. Der Soldat kann der Maschine vertrauen und ihren Betrieb nicht angemessen überwachen. Zum Beispiel, Missy Cummings , Direktor des Duke University Human and Autonomy Laboratory, stellt fest , dass , wenn es darum geht, autonome Autos „Fahrer , die ihre Autos denken , sind besser in der Lage , als sie anfälliger für erhöhte Zustände von Ablenkungen können sind und somit bei höhere Unfallgefahr.“

Natürlich kann das autonome Verhalten einer Waffe nicht immer aktiviert sein – ein Mensch kann je nach Situation in, in oder außerhalb der Schleife sein. Südkorea hat eine Wachwaffe entlang der entmilitarisierten Zone mit Nordkorea namens SGR A-1 stationiert , die Berichten zufolge auf diese Weise operiert. Das Risiko ändert sich je nachdem, wie und wann die vollautonome Funktion eingeschaltet wird. Der autonome Betrieb standardmäßig birgt offensichtlich mehr Risiken als der autonome Betrieb, der nur auf enge Umstände beschränkt ist.

Welche Nutzlast hat eine autonome Waffe? Jemanden aus Versehen zu erschießen ist schrecklich, aber weitaus weniger als aus Versehen einen Atomsprengkopf zur Detonation zu bringen. Ersteres könnte einen Unschuldigen das Leben kosten, letzteres jedoch Hunderttausende. Politische Entscheidungsträger können sich auf die größeren Waffen konzentrieren, indem sie die Kosten von Fehlern erkennen und potenziell die Risiken autonomer Waffen reduzieren. Welche Nutzlasten autonome Waffen genau haben werden, ist jedoch unklar. Theoretisch könnten autonome Waffen mit Waffen, Bomben, Raketen, Störsendern für elektronische Kriegsführung, Lasern , Mikrowellenwaffen, Computern für Cyberangriffe , chemischen Waffen , biologischen Waffen, Atomwaffen und allem dazwischen bewaffnet sein .

Worauf zielt die Waffe ab? Ob eine autonome Waffe auf einen Panzer, einen Marinezerstörer oder einen Menschen schießt, spielt eine Rolle. Aktuelle auf maschinellem Lernen basierende Systeme können einen Landwirt nicht effektiv von einem Soldaten unterscheiden. Bauern könnten ein Gewehr halten, um ihr Land zu verteidigen, während Soldaten einen Rechen verwenden könnten, um einen Geschützturm umzustoßen. Aber auch eine adäquate Klassifizierung eines Fahrzeugs ist schwierig, da verschiedene Faktoren eine genaue Entscheidung verhindern können. In einer Studie beispielsweise führte das Verdecken der Räder und der Hälfte der Frontscheibe eines Busses dazu, dass ein auf maschinellem Lernen basierendes System den Bus als Fahrrad einstufte. Die Kanone eines Panzers kann in einer offenen Umgebung leicht von einem Schulbus zu unterscheiden sein, aber nicht, wenn Bäume oder Gebäude wichtige Teile des Panzers wie die Kanone selbst verdecken.

Wie viele autonome Waffen werden eingesetzt? Mehr autonome Waffen bedeuten mehr Möglichkeiten zum Scheitern. Das ist die Grundwahrscheinlichkeit. Aber wenn autonome Waffen kommunizieren und ihre Aktionen koordinieren, wie etwa in einem Drohnenschwarm, steigt das Risiko, dass etwas schief geht. Die Kommunikation birgt das Risiko einer Fehlerkaskade, bei der ein Fehler einer Einheit mit einer anderen geteilt wird. Kollektive Entscheidungsfindung birgt auch das Risiko eines emergenten Fehlers, bei dem sich die richtige Interpretation zu einem kollektiven Fehler summiert. Betrachten Sie das Gleichnis von den Blinden und dem Elefanten, um auftretende Fehler zu veranschaulichen. Drei Blinde hören, dass ein seltsames Tier, ein Elefant, in die Stadt gebracht wurde. Ein Mann betastet den Rüssel und sagt, der Elefant sei dick wie eine Schlange. Ein anderer betastet die Beine und sagt, es sei wie eine Säule. Ein dritter fühlt die Seite des Elefanten und beschreibt ihn als Mauer. Jeder nimmt die physikalische Realität genau, wenn auch unvollständig wahr, aber ihre individuellen und kollektiven Interpretationen dieser Realität sind falsch. Würde ein Drohnenschwarm zu dem Schluss kommen, dass der Elefant ein Elefant, eine Schlange, eine Säule, eine Mauer oder etwas ganz anderes ist?VERBUNDEN:Jetzt ansehen – Die neue nukleare Haltung Großbritanniens: Was sie für die globale Nuklearordnung bedeutet

Wo werden autonome Waffen eingesetzt? Ein bewaffnetes, autonomes Bodenfahrzeug, das einen schneebedeckten antarktischen Gletscher durchstreift, hat fast keine Chance, unschuldige Menschen zu töten. Dort lebt nicht viel und die Umgebung ist meist karg und die Bordsensoren des Fahrzeugs können kaum behindert oder verwechselt werden. Aber das gleiche Fahrzeug, das durch die Straßen von New York City oder Tokio streift, ist eine andere Sache. In Städten hätte das KI-System viele Fehlermöglichkeiten: Bäume, Schilder, Autos, Gebäude und Menschen könnten die korrekte Zielbewertung blockieren.

Seegestützte autonome Waffen könnten weniger fehleranfällig sein, nur weil es einfacher ist, zwischen einem militärischen und einem zivilen Schiff mit weniger Hindernissen zu unterscheiden, als dies bei einem Schulbus und einem Schützenpanzer der Fall ist. Sogar das Wetter zählt. Eine aktuelle Studie ergab, dass bei Nebel die Genauigkeit eines KI-Systems, das zur Erkennung von Hindernissen auf Straßen verwendet wird, auf 58 Prozent reduziert wurde, verglichen mit 92 Prozent bei klarem Wetter. Natürlich kann auch schlechtes Wetter Menschen bei der effektiven Zielklassifizierung behindern, daher ist eine wichtige Frage, wie die KI-Klassifizierung im Vergleich zur menschlichen Klassifizierung abschneidet.

Wie gut ist die Waffe getestet? Jedes professionelle Militär würde überprüfen und testen, ob eine autonome Waffe wie gewünscht funktioniert, bevor es Soldaten und allgemeinere strategische Ziele gefährdet. Das Militär testet jedoch möglicherweise nicht auf alle Komplexitäten, die eine autonome Waffe verwirren können, insbesondere wenn diese Komplexitäten unbekannt sind . Die Tests werden auch auf den erwarteten Nutzungen und Betriebsumgebungen basieren, die sich ändern können, wenn sich die strategische Landschaft ändert. Eine autonome Waffe, die in einer Umgebung robust getestet wurde, kann beim Einsatz in einer anderen versagen. Seattle hat viel mehr Nebeltage als Riad, aber viel weniger Sandstürme.

Wie haben sich die Gegner angepasst? In einem Gefecht mit autonomen Waffen werden Gegner versuchen, Operationen durcheinander zu bringen, was möglicherweise nicht sehr schwierig ist. OpenAI – ein weltweit führendes KI-Unternehmen – hat ein System entwickelt, das einen Apfel mit 85,6 Prozent Vertrauen als Granny Smith klassifizieren kann . Kleben Sie jedoch ein Stück Papier mit der Aufschrift „iPod“ auf den Apfel, und das Bildverarbeitungssystem kommt mit 99,7-prozentiger Sicherheit zu dem Schluss, dass der Apfel ein iPod ist. In einem Fall veränderten KI-Forscher ein einzelnes Pixel in einem Bild, was dazu führte, dass ein Bildverarbeitungssystem einen Tarnkappenbomber als Hund einstufte. Im Krieg könnte ein Gegner einfach „Schulbus“ auf einen Panzer malen oder, bösartiger, „Panzer“ auf einen Schulbus und möglicherweise eine autonome Waffe täuschen.

Wie weit verbreitet sind autonome Waffen? Staaten und nichtstaatliche Akteure unterscheiden sich natürlich in ihrer Risikotoleranz, basierend auf ihren Strategien, Kulturen, Zielen und ihrer allgemeinen Sensibilität für moralische Kompromisse. Je einfacher es ist, autonome Waffen zu beschaffen und einzusetzen, desto eher kann die internationale Gemeinschaft damit rechnen, dass die Waffen von apokalyptischen Terrorgruppen, ruchlosen Regimen und Gruppen eingesetzt werden, die gegenüber dem Fehlerrisiko schlichtweg unempfindlich sind. Als Stuart Russell, ein Professor für Informatik an der University of California, Berkeley, bemerkt gerne: „[Mit] drei guten Absolventen und möglicherweise der Hilfe einiger meiner Robotik-Kollegen wird es ein Semesterprojekt sein, eine Waffe zu bauen, die könnte in das Gebäude der Vereinten Nationen kommen, den russischen Botschafter finden und ihm ein Paket überbringen.“ Glücklicherweise werden technischer Scharfsinn, Organisation, Infrastruktur und Ressourcenverfügbarkeit die Entwicklung autonomer Waffen einschränken . Kein einsamer Wolf-Terrorist wird jemals eine autonome F-35 in seiner Garage bauen.

Das Risiko autonomer Waffen ist kompliziert, variabel und mehrdimensional – das Was, Wo, Wann, Warum und Wie des Einsatzes ist von Bedeutung. Am risikoreichsten Ende des Spektrums stehen autonome Atomwaffen und der Einsatz kollaborativer, autonomer Schwärme in stark urbanen Umgebungen, um feindliche Infanterie zu töten; am unteren Ende sind autonomie-optionale Waffen, die in unbewohnten Gebieten als Verteidigungswaffen verwendet werden und nur verwendet werden, wenn der Tod unmittelbar bevorsteht. Wo Staaten die Grenze ziehen, hängt davon ab, wie ihre Militärs und Gesellschaften das Fehlerrisiko gegen die militärische Notwendigkeit abwägen. Aber um überhaupt eine Grenze zu ziehen, bedarf es eines gemeinsamen Verständnisses, wo das Risiko liegt.

Wie die Coronavirus-Krise zeigt, brauchen wir die Wissenschaft jetzt mehr denn je.

Das Bulletin hebt Expertenstimmen über den Lärm. Aber als unabhängige, gemeinnützige Medienorganisation sind unsere Aktivitäten auf die Unterstützung von Lesern wie Ihnen angewiesen. Helfen Sie uns, weiterhin Qualitätsjournalismus zu liefern, der Führungskräfte zur Rechenschaft zieht. Ihre Unterstützung unserer Arbeit auf allen Ebenen ist uns wichtig . Im Gegenzug versprechen wir, dass unsere Berichterstattung verständlich, einflussreich, wachsam, lösungsorientiert und fair sein wird. Zusammen können wir einen Unterschied machen.Unterstützen Sie das Bulletin

Schlagworte: Libyen , Türkei , Drohnen , tödliche autonome Waffen

Themen: Analyse

Posted in Afrika, Asien, Ethik, Friedensarbeit, Friedensbewegung, Friedensforschung, Friedensjournalismus, Friedenspädagogik, Friedenspolitik, Gewaltprävention, Global, Internationales Strafrecht, Kriminalität, Krisenregion, Menschenrecht, Rüstungsexport, Unfrieden, Völkerrecht, Wirtschaft